打破「想得到卻做不到」的界線

「想像力,常常被執行的現實所限制。」在 GMI Cloud,我們選擇改寫這個現實。創意,不該停在算力不足的那一刻。每一次 AI 的突破,都讓人類更靠近未來。但過去的工具太複雜、太遲鈍、太工程師導向。創作者面對的,不該是等待 GPU 排程的進度條。Inference Engine 2.0 拆除創意與執行之間的牆,讓每個靈感,都能瞬間轉化為作品。從 prompt 到成品,不再是遙遠的旅程,而是一個 即時生成的無縫流。

⚡ 關鍵亮點:比靈感更快一步

- 效能再進化: 回應速度最高提升 1.46×

- 吞吐量再突破: 實際工作負載提升 25–49%

- 全模態整合: 文字、圖片、音訊、影片一次搞定

- 全球即時擴展: 零設定上線,全新 Console 為創作者與工程師而生

🎬 給創作者:創意,不再受限

你不該需要懂模型排程或 API 配置,才能創作出動人的作品。不論是導演、影像藝術家、還是創意工作室,Inference Engine 2.0 讓你從構想到發布,一氣呵成。

⚡ 支援最強多模態模型:

- 🎬 影片生成: Veo 3.1、Sora 2 Pro、Pixverse、Hailuo 2.3

- 🖼 圖像生成: Seedream、Flux-kontext-pro、Seededit

- 🎙 語音合成: Minimax TTS、ElevenLabs TTS

想像一下:

- 放上一張草圖,它立刻變成分鏡;

- 加入對白,畫面自動成為劇情;

- 再按一下,配音、上色、光影全自動完成。

這不是未來,這是 Inference Engine 2.0。

你無需重寫任何代碼,就能在 GMI Cloud 直接完成生成流程。背後的即時 GPU 管線確保穩定、流暢、毫不延遲。每一毫秒的提升,都讓靈感被更快實現。讓創作不再等待、品質不再妥協。

⚙️ 給開發者:重新定義推論引擎

如果你曾部署過模型,就會知道延遲、碎片化與持續優化的痛苦。Inference Engine 2.0 從基礎結構到 API,全面重構推論引擎的定義,為多模態時代而設。

新功能亮點:

1. 智慧記憶系統

系統會記住模型已處理的內容,並透過分層式 KV Cache 共用記憶體,加速相同資料的再利用。實測最高可達 49% 吞吐提升、30% 成本降低。

2. 自動彈性擴展

當流量暴增時,IE 2.0 能自動從全球資料中心調度 GPU,實現 2.34× 更快配置速度、8.2× 更少停機時間,不怕爆紅事件讓後端當機。

3. 精準輸出,毫不打折

沒有偷工減料的速成效果。沒有隱藏壓縮。每個 token、畫面、像素,都與開發端一致。

4.多模態原生架構

單一管線即能智慧分流文字、影像、音訊與影片工作負載,讓開發者可依需求自由切換「效能 / 成本 / 畫質」模式。

在 GMI Cloud,穩定效能不是追求,而是標準。Inference Engine 2.0 讓基礎設施主動配合你的創造節奏。

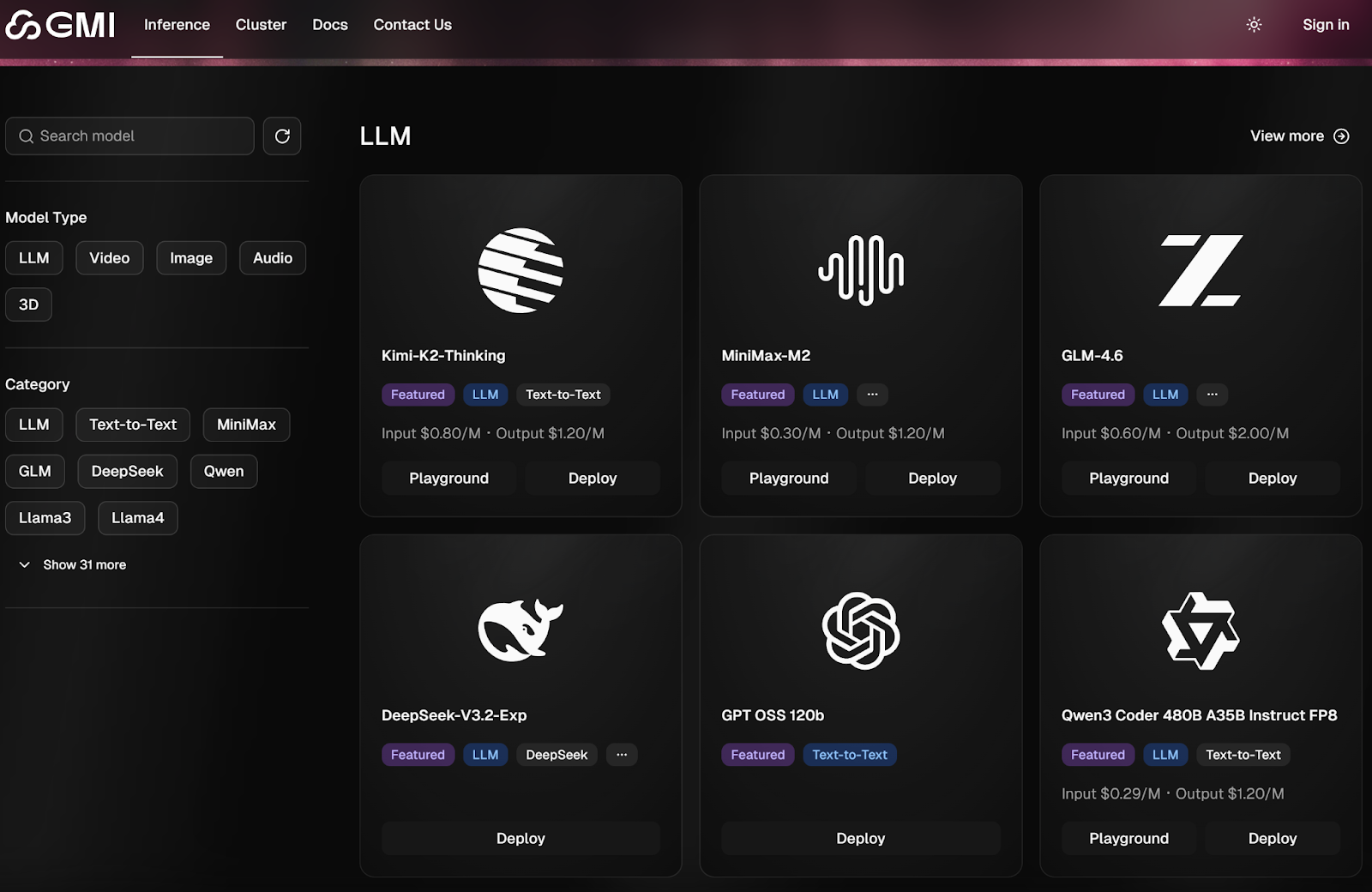

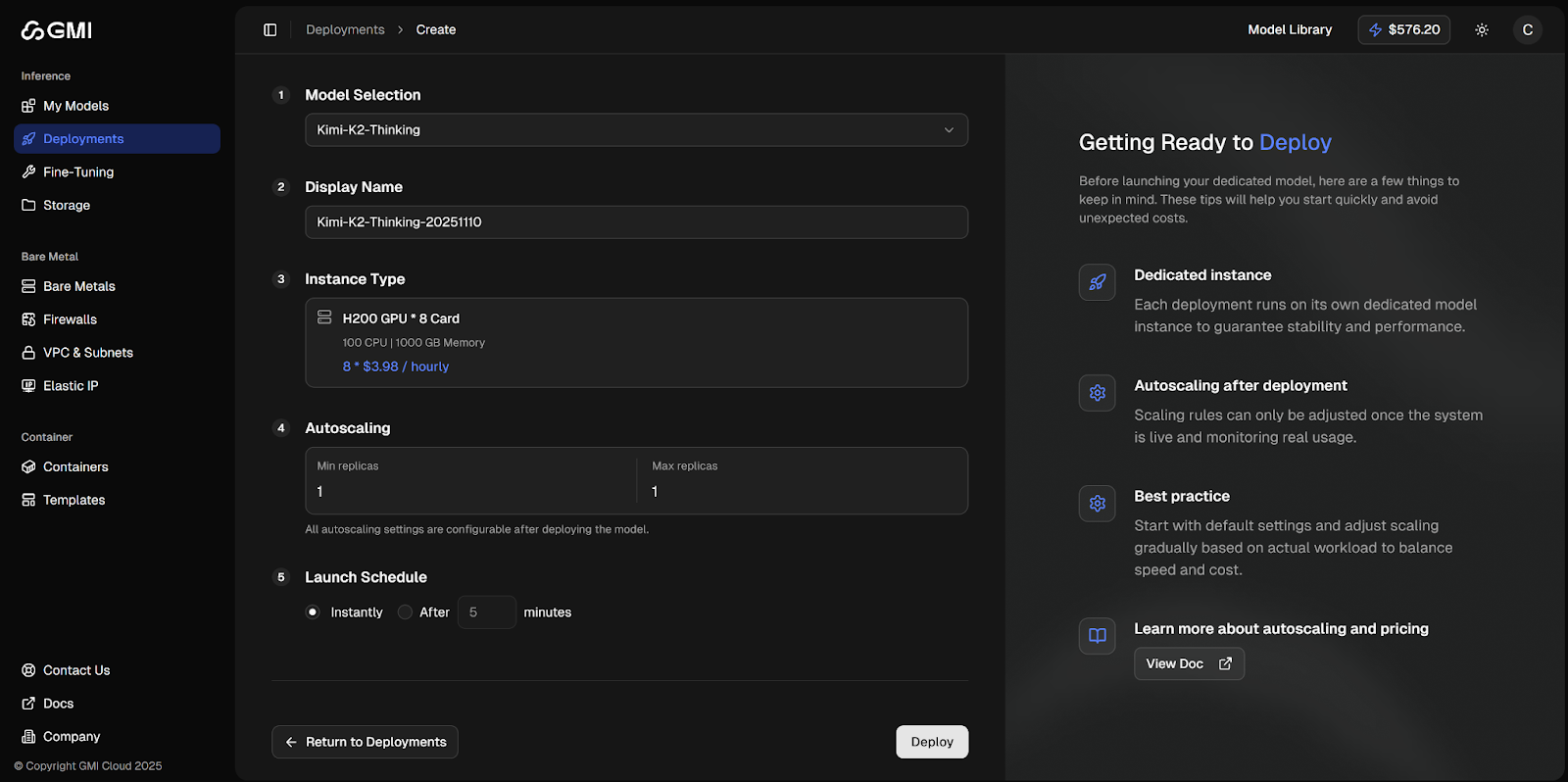

🖥 統一控制台:創作者與工程師的共同舞台

全新的 Inference Engine 2.0 Console,是你的 AI 創作中樞。打開後,模型、端點、用量、工作流程全都一目了然。

- 🚀 一鍵部署

立即啟動 serverless playground 或專用端點,不必寫 YAML。 - 🔍 模型搜尋與部署

支援 Veo、Flux、Minimax、Hailuo 等頂級模型,皆預設為 GMI 架構最佳化版本。 - 🎨 專注設計

淺色/深色模式、響應式介面,適合長時間專注創作。

我們不只是提升效能,我們讓技術變得更貼近創作,讓靈感無須等待。

🚀 加入 AI 的新世代

我們打造 Inference Engine 2.0,是為了讓 AI 成為每個人手中的創作工具。從 copilots 到影片生成、從應用到平台開發,這是你邁向多模態時代的創作畫布。

我們迫不及待想看看您發揮什麼!

👉 立即試用推論引擎 2.0