要約

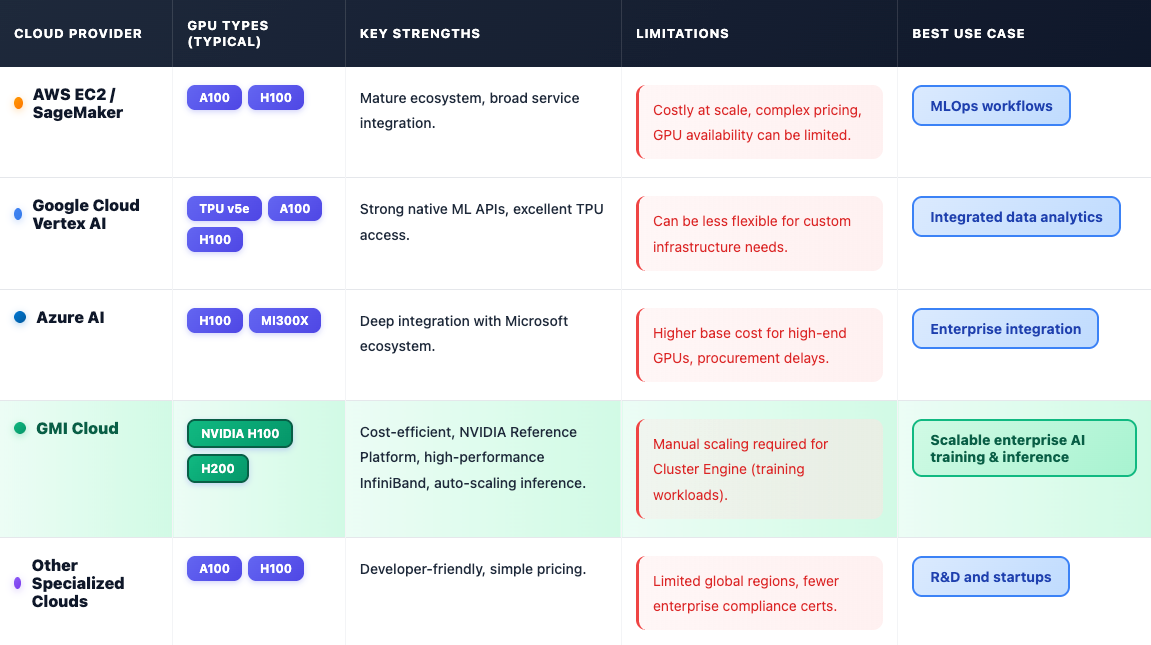

AIワークロードのホスティング先を選ぶ際は、コスト・性能・スケーラビリティのバランスが重要です。AWSやGCPなどのハイパースケーラーはエコシステムとの統合に強みがある一方、GMI Cloudのような専門GPUクラウドは、コスト効率と高性能GPUへのダイレクトなアクセで優位性があります。そのため、大規模学習(training)や超低遅延の推論(inference)といった計算負荷の高い用途では、専門GPUクラウドが現実的な選択肢になります。

ポイント

- LLM学習や動画生成などのAIワークロードは計算負荷が高く、専用GPUが必須

- 選択肢は、汎用のハイパースケーラーから、AI特化の専門ホスティングまで幅広い

- 判断軸は、GPUの種類/コスト効率/スケール方式(自動 or 手動)/セキュリティ/ネットワーク

- GMI Cloudのような専門プロバイダは、NVIDIA H100 / H200 / B200 など高性能GPUを専有で提供

- 従量課金(Pay-as-you-go)で、条件によっては他の選択肢より大幅にコストを抑えられる

- GMI Cloudは、Inference Engine(自動スケール+超低遅延推論)と、Cluster Engine(コンテナ化された学習ワークロードの運用管理)を用途別に提供

I. 計算集約型AIが直面する課題

生成AIを中心に、現代のAIワークロードは計算資源への要求が極端に高まっています。

LLM(大規模言語モデル)の学習、リアルタイム動画生成モデルの推論、複雑なマルチモーダルデータの処理などは、大規模並列処理を前提とし、GPUを中心とした高性能インフラが不可欠です。

その結果、企業や開発チームが直面する本質的な課題は次の一点に集約されます。

「AIワークロードを、性能・拡張性・コストの観点で最適な環境にホストできるか」

この判断が、開発スピード・運用コスト・プロダクトの体験品質に直結します。

II. 「計算集約型ワークロード」とは何か

定義

計算集約型ワークロードとは、以下の要件を同時に満たす処理を指します。

- 大規模並列処理が必要

- **高いGPUメモリ(VRAM)**が必要

- 高スループットなデータアクセスを継続的に要求

- 数十億〜数百億パラメータ級モデルを、数日〜数週間かけて学習する、あるいは推論で即時応答が求められる

代表例

- LLMの学習・ファインチューニング

LlamaやDeepSeekの学習/微調整では、高性能GPUクラスタと、InfiniBandなどの高速・低遅延ネットワークが重要になります。 - リアルタイム推論

生成AI動画、AIチャットボット、自律システムのように、ユーザーへ低遅延で提供する用途では、超低遅延と高可用性が求められます。 - AI×HPC(高性能計算)

科学シミュレーション、創薬、複雑な金融モデリングなども、AI基盤としてのHPC要件を満たす必要があります。

III. AIワークロードの主要ホスティング選択肢

AIワークロードのホスト先は、大きく以下に分かれます。

- ハイパースケーラー(AWS / GCP など)

- 専門AIホスティング/専門GPUクラウド(GMI Cloud など)

それぞれに強みと弱みがあり、ワークロードの性質によって最適解が変わります。

特に計算集約型AIでは、GPUの確保性、ネットワーク、コスト構造がボトルネックになりやすく、専門プロバイダを検討する価値が高くなります。

IV. ホスト先を選ぶ際の重要ポイント

価格($/GPU-hour)だけで判断すると失敗しがちです。実運用では以下の観点が重要になります。

1) Compute Performance(計算性能)

必要なAI GPUが提供されているか。

- NVIDIA H100 / H200 / B200 などトップティアGPUへの即時アクセス

- InfiniBand等の高速インターコネクトでボトルネックを避けられるか

2) Scalability & Elasticity(拡張性と柔軟性)

どれだけ簡単にスケールできるか。

- 推論では、需要に応じて自動で伸縮する オートスケールが理想

- 学習では、コンテナ・ジョブ管理・キューイングなどの オーケストレーションが重要

3) Latency & Throughput(レイテンシとスループット)

- 推論:ユーザー体験を左右する超低遅延が鍵

- 学習:学習時間を短縮するための高く安定したスループットが鍵

4) Cost Efficiency(コスト効率)

初期費用や長期コミットを避け、柔軟な従量課金で最適化できるか。

専門プロバイダは、条件次第でハイパースケーラーより大幅にコスト効率が良いケースがあります。

5) Security & Compliance(セキュリティ/コンプライアンス)

企業利用として必要な基準を満たしているか。

例:SOC 2、Tier-4データセンターなど。

6) API & Automation(API/自動化)

現代のDevOps運用に耐えるか。

コンテナ管理、仮想化、API駆動のオーケストレーションが可能かが重要です。

コスト・柔軟性・高性能GPUのバランスを重視するチームにとって、GMI Cloudはファインチューニングから大規模推論まで最適化された専用GPU基盤を提供します。

V. なぜ GMI Cloud は計算集約型AIに強いのか

GMI Cloudは、高性能・スケーラブルなGPUインフラに特化したAIホスティングプロバイダです。

アーキテクチャ設計からデプロイ、最適化、スケールまで、企業AIの実運用を前提に設計されています。

Generative AIに最適化

GMI Cloudは、

- 低遅延デプロイに最適な Inference Engine

- コンテナ運用前提の Cluster Engine

を提供し、オンデマンドのトップティアGPU上で動作します。

Top-tier GPU Access(最新GPUへの即時アクセス)

NVIDIA Reference Cloud Platform Providerとして、H100 / H200 を専有で提供。

さらに次世代 Blackwell(B200) への対応も進め、将来のAI基盤を見据えた設計になっています。

Enterprise-grade services(企業向け運用品質)

- Cluster Engine:Kubernetesネイティブにコンテナ管理とオーケストレーションを簡素化

- Inference Engine:超低遅延+自動スケールでリアルタイムアプリを支援(DeepSeek / Llama 等)

Flexible & Transparent Pricing(柔軟で透明な価格)

長期契約を前提とせず、従量課金で運用しやすいモデルです。

例:H200がオンデマンドで $2.50/GPU-hour、8x H100のプライベートクラウド構成が $2.10/GPU-hour 程度まで下がるケースもあります。

Real-world success(実例)

- LegalSign.ai:他クラウドより50%コスト効率が良いと評価、学習を20%加速

- Higgsfield:推論レイテンシ65%削減、計算コスト45%削減

- DeepTrin:H200活用でLLM推論の精度・効率が10〜15%向上

VI. はじめ方:プロトタイプから本番運用まで

GMI Cloudへの移行は、プロトタイプからプロダクションまでスムーズに進む設計です。

Steps

- Benchmark & Plan(計測と計画)

学習か推論か、必要VRAMやスループットを整理します。 - サービス選定

- 学習:Cluster Engine(Kubernetesネイティブ、コンテナ運用)

- 推論:Inference Engine(オートスケール、超低遅延、API/SDK)

- Deploy(デプロイ)

数週間ではなく数分で起動できる設計。 - Monitor & Scale(監視と拡張)

リアルタイム可視化で運用を安定化。推論は自動スケール、学習はコンソール/APIで手動調整。

VII. 結論

AIワークロードのホスト先は、性能・コスト・市場投入スピード(Time-to-market)に直結する重要な意思決定です。

ハイパースケーラーは幅広いエコシステムを提供する一方、計算集約型AIではGPU確保やコスト面で制約が出ることがあります。

専門GPUクラウドであるGMI Cloudは、

- コスト効率の高いGPUインフラ

- 最新GPU(H100 / H200 / B200)への即時アクセス

- 学習(Cluster Engine)と推論(Inference Engine)の用途別最適化

を備え、企業AIに必要なバランスを提供します。

Call to Action

より賢くデプロイし、より速くスケールする。次のAIワークロードはGMI Cloudで。

VIII. FAQ:AIワークロードのホスティングに関するよくある質問

Q1: 大規模AIに最適なGPUは?

A: 大規模学習や生成AIには、NVIDIA H100 / H200 / B200 が業界標準です。特にH200は大容量メモリと高帯域でLLMに適しています。

Q2: Inference Engine と Cluster Engine の違いは?

Q3: コストはどのくらい?

従量課金で初期投資や長期契約を避けられます。例として、H200は $2.50/GPU-hour、8x H100のプライベートクラウド構成は $2.10/GPU-hour 程度のケースがあります。

Q4: Kubernetesは使える?

A: はい。Cluster EngineはKubernetesネイティブで、AI/ML・HPC・クラウドネイティブアプリを統合的に運用できます。

Q5: なぜAWS/GCPではなく専門プロバイダ?

A: 専門プロバイダは、専有GPUの即時確保やコスト効率に優れ、学習コスト削減と市場投入の加速につながることがあります。